再拖一年才换硬件,你的长视频模型可能永远跑不完,因为英伟达刚刚把 “上下文天花板” 直接拔高了十倍。

很多人没意识到,现在最卡脖子的不是模型大小,而是 “一口气能读多长”。一段十分钟的 4K 视频转成 tokens,轻松突破两百万,老卡得切八次才能喂完,每次切都丢细节,画面直接崩。Rubin CPX 把这两百万一口气吞下,还把延迟压到原来的六分之一,相当于原本一周的渲染任务,现在一个通宵搞定。它怎么做到的?拆开看其实粗暴又聪明。

传统 GPU 像一辆大卡车,货箱(HBM)贵得要命,却只用来拉最后几公里;前面的几百公里 “上下文搬运” 其实用不到那么贵的货箱。Rubin 干脆把这段路交给另一辆车 ——CPX 专用芯片,货箱换成便宜又快的 GDDR7,128GB 一条,带宽拉到 1.7PB/s,算力堆到 30petaFLOPs,专门对付 “前面那段苦力活”。生成阶段再换回 Rubin GPU,两边各干各的,资源不再打架。

全球人工智能算力芯片龙头英伟达于美国当地时间 9 月 9 日宣布,推出专为长上下文工作负载设计的专用 GPU Rubin CPX,用于翻倍提升当前 AI 推理运算的工作效率,特别是编程、视频生成等需要超长上下文窗口的应用。作为行业首创之举,英伟达的新品在硬件层面上分拆了人工智能推理的计算负载。

英伟达介绍称,推理过程包括两个截然不同的阶段:上下文阶段与生成阶段,两者对基础设施的要求本质上完全不同。上下文阶段属于计算受限(compute-bound),需要高吞吐量的处理能力来摄取并分析大量输入数据,从而生成首个输出 token。相反,生成阶段则属于内存带宽受限(memory bandwidth-bound),依赖高速的内存传输和高带宽互联(如 NVLink),以维持逐个 token 的输出性能。当前顶级的 GPU 都是为了内存和网络限制的生成阶段设计,配备昂贵的 HBM 内存,然而在解码阶段并不需要这些内存。因此,通过分离式处理这两个阶段,并针对性地优化计算与内存资源,将显著提升算力的利用率。

据悉,Rubin CPX 专门针对 “数百万 tokens” 级别的长上下文性能进行优化,具备 30petaFLOPs 的 NVFP4 算力、128GB GDDR7 内存。英伟达估计,大约有 20% 的 AI 应用会 “坐等” 首个 token 出现。例如解码 10 万行代码可能需要 5-10 分钟。而多帧、多秒的视频,预处理和逐帧嵌入会迅速增加延迟,这也是为什么当前的视频大模型通常仅用于制作短片。

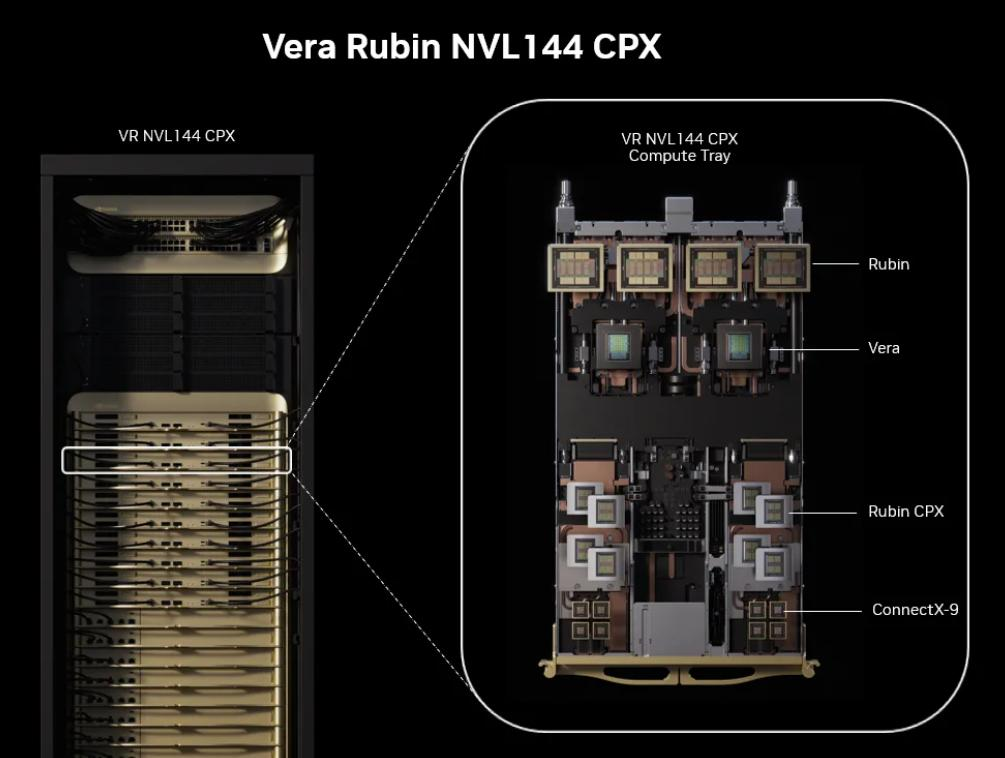

英伟达 CEO 黄仁勋表示,CPX 是首款专为需要一次性处理大量知识(数百万级别 tokens),并进行人工智能推理的模型而构建的芯片。需要说明的是,Rubin 就是英伟达将在明年发售的下一代顶级算力芯片,所以基于 Rubin 的 CPX 预计也要到 2026 年底出货。下一代英伟达旗舰 AI 服务器的全称叫做 NVIDIA Vera Rubin NVL144 CPX—— 集成 36 个 Vera CPU、144 块 Rubin GPU 和 144 块 Rubin CPX GPU。

英伟达透露,搭载 Rubin CPX 的 Rubin 机架在处理大上下文窗口时的性能,能比当前旗舰机架 GB300 NVL72 高出最多 6.5 倍。据悉,下一代旗舰机架将提供 8exaFLOPs 的 NVFP4 算力,比 GB300 NVL72 高出 7.5 倍。同时单个机架就能提供 100TB 的高速内存和 1.7PB/s 的内存带宽。

英伟达之所以要在 Rubin GPU 边上再配一块 Rubin CPX GPU,自然是为了显著提升数据中心的算力效率 —— 用户购买英伟达的芯片将能赚到更多的钱。英伟达表示,部署价值 1 亿美元的新芯片,将能为客户带来 50 亿美元的收入。

有人担心买新机器等于重新盖机房。其实英伟达留了后手:NVL144 机架可以混搭,老用户先插 CPX 扩展柜,算力立刻翻倍,不用一次换全套。官方给的账也算得直白 ——1 亿美元设备换 50 亿美元增量收入,主要省在电费和时间。以前跑长视频模型要 72 张 H100 同时在线,现在 144 张 CPX 就能顶上,功耗反而降三成,一年光电费就能省出一辆特斯拉。

更现实的变化在应用层。做 AI 编程的同行试过,把整份百万行代码塞进窗口,Rubin CPX 能在十秒内给出跨文件重构建议,而老卡直接超时退出。做动画的团队实测,同样一段 15 秒 4K 片段,原本需要拆成 150 小段逐帧生成,现在一次性出片,角色动作连贯,不再出现 “跳帧鬼畜”。连做客服机器人的公司都偷着乐 —— 长文档总结不用再截断,客户提问再长也能一次答完,满意度肉眼可见地涨。

当然,别急着掏钱包。芯片 2026 年底才发货,真正铺到云厂商可能得 2027 年中。这段空窗期,英伟达留了 “软件补丁”:新版 TensorRT-LLM 已经支持上下文分段模拟,虽然速度只有 CPX 的三分之一,但至少能让开发者提前适配。换句话说,现在开始改代码,两年后换硬件就能直接起飞,而不是从零补课。一句话总结:Rubin CPX 不是简单的 “更快”,而是把 “长上下文” 从奢侈品变成日用品。谁先上车,谁就能把对手甩在起跑线外。